La responsabilité juridique des dommages causés par l'IA : une législation bien intentionnée mais mal conçue

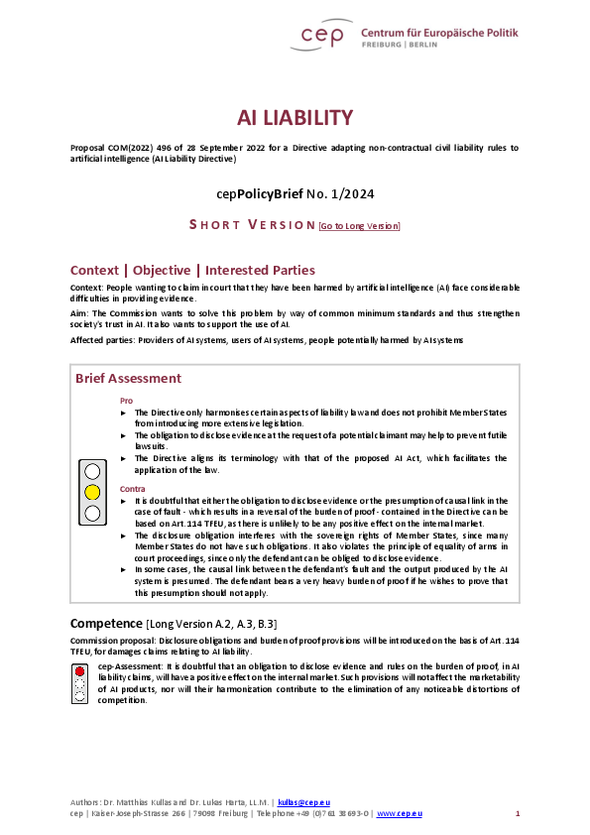

Jusqu'à présent, la responsabilité relative aux dommages résultant de l’utilisation d’une intelligence artificielle (IA) a souvent posé des problèmes de preuve aux parties lésées, car les systèmes d'IA sont généralement complexes et opaques. La Commission souhaite donc minimiser ces problèmes en instaurant une obligation de divulgation des preuves et une présomption de causalité - c’est à dire qu’il reviendra au fournisseur d’IA de prouver que son programme n’est pas à l’origine du dommage causé.

Les Analyses du cep

Par exemple, si une voiture autonome guidée par une IA cause un accident, il reviendra désormais au constructeur de prouver que l’algorithme n’en est pas responsable. De même pour les discriminations résultant supposément de l’utilisation d’une IA, des dommages causés par des deepfakes, ou encore de la violation de normes contractuelles ou juridiques.

Bien que le Centre de Politique Européenne (Centre for European Policy, cep) estime que cette proposition est la bienvenue, il émet des réserves d'ordre juridique. La loi ne devrait pas être basée sur l'article 114 du TFUE, lequel permet à la Commission européenne de s’opposer à toute décision d’un État membre contrevenant au principe de la libre circulation des biens. Le cep estime en effet que la directive ne devrait pas entrainer d’effet sur la commercialisation d’IA et donc sur le marché intérieur.

« La présomption de causalité est appropriée au vu de la complexité et du manque de transparence des systèmes d'IA. L'adaptation des règles relatives à la charge de la preuve met la partie lésée sur un pied d'égalité avec les fournisseurs d'IA en les obligeant à fournir des preuves qu’ils ne sont pas responsables d’éventuels préjudices », explique Matthias Kullas, expert numérique du cep, qui a analysé les propositions de la Commission.

M. Kullas se félicite de cette nouvelle orientation. « Si des personnes veulent affirmer devant un tribunal qu'elles ont été lésées par l'intelligence artificielle, elles sont confrontées à des difficultés particulières pour fournir des preuves. La Commission souhaite résoudre ce problème grâce à des normes minimales communes et renforcer ainsi la confiance de la société dans l'IA. Cette approche est la bonne », souligne l'expert du cep.

La directive autorise également les juridictions nationales à ordonner, sur demande, la divulgation de preuves pertinentes concernant un système d'IA à haut risque spécifique. La définition d'un système d'IA à haut risque dépend largement de la fonction et de l'objectif du système et de l'impact potentiel sur la santé, la sécurité et les droits fondamentaux des personnes physiques. « L'obligation de divulgation peut contribuer à éviter des poursuites judiciaires sans issue. Cependant, elle interfère de manière disproportionnée avec les droits souverains des États membres, auxquels de telles obligations sont étrangères », critique M. Kullas.